Mit der Deep-Fake-Technik lassen sich täuschend echte Videos von beliebigen Personen fälschen. Solche Videos existieren bereits mit Politikern wie Barack Obama, Wladimir Putin und Angela Merkel. Mit der Technik sind auch gefälschte pornografische Filme mit bekannten Schauspielerinnen und Musikerinnen entstanden.

„Wir stehen am Beginn einer Ära, in der unsere Feinde es so aussehen lassen können, als ob jeder zu jedem Zeitpunkt alles Mögliche gesagt hat – sogar wenn sie so etwas nie sagen würden.“ Barack Obama schaut ernst in die Kamera und gibt dann einige Beispiele. „Wie wäre es mit: Präsident Donald Trump ist ein kompletter Volltrottel.“

Tatsächlich ist die Person in dem Video nicht der ehemalige US-Präsident Barack Obama. Es handelt sich um eine Fälschung. Das Video ist ein gemeinsames Projekt des Kabarettisten Jordan Peele mit der Internetplattform BuzzFeed. Der Spuk wird aufgelöst und das Video gibt nicht vor, echt zu sein.

Fake bedeutet im Englischen Fälschung und Deep steht für Deep Learning, eine Methode, mit der heutige Künstliche Intelligenzen trainiert werden. Diese Methode ermöglicht es, in relativ kurzer Zeit und mit recht wenig Aufwand das Gesicht einer Person in einem Video durch ein anderes zu ersetzen.

Fälschungen gab es schon immer. Neu ist, wie der Nachrichtensender CNN schreibt, dass Computer und nicht Menschen die Arbeit jetzt machen. Dafür braucht ein Programm zuerst eine Menge Bilder beider Personen. Es „lernt“ deren Gesichtszüge und Mimik und ist danach in der Lage, Videos zu erzeugen, in denen die Gesichter samt Mimik ausgetauscht werden.

Deep Fake beschäftigt die Politik. In den USA zeigten sich sowohl Republikaner wie auch Demokraten besorgt. Unter anderem der republikanische Spitzenpolitiker Marco Rubio äußerte sich dazu. Die Forschungsabteilung des Verteidigungsministeriums „Darpa“ arbeitet CNN zufolge mit Experten anderer Regierungen zusammen an Methoden, um gefälschte Videos besser erkennen zu können.

Computer analysiert Gesichtszüge und Mimik

Deep-Fake-Videos von Prominenten herzustellen, ist derzeit einfacher, weil von ihnen mehr Videos verfügbar sind, mit denen der Algorithmus trainiert werden kann. Potenziell können allerdings nicht nur berühmte Menschen Opfer solcher Veröffentlichungen werden.

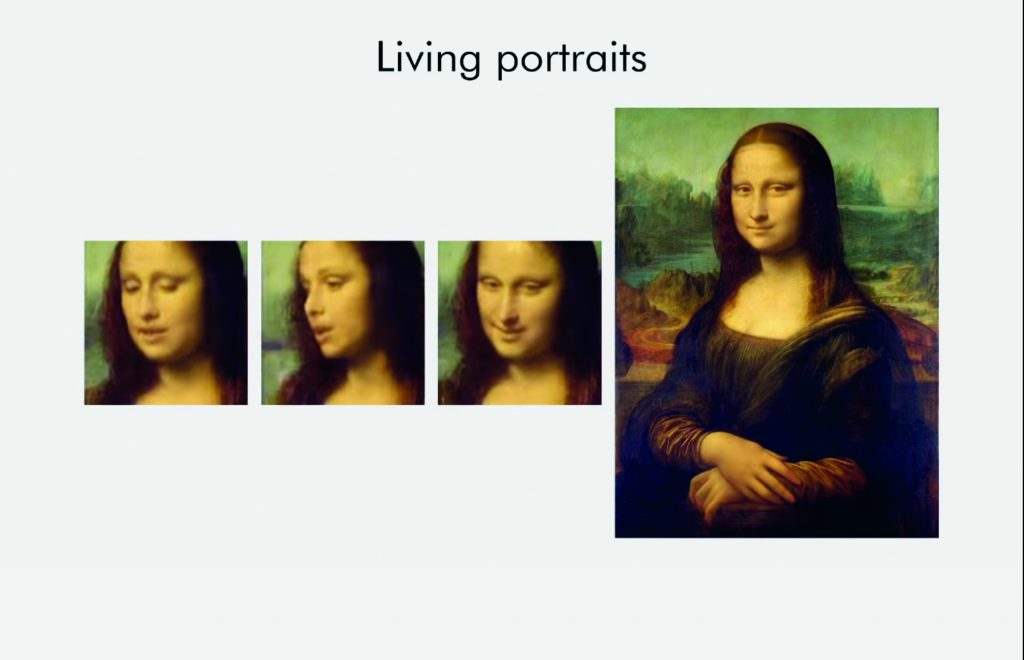

Forschern des Samsung AI Center in Moskau ist es gelungen, mithilfe einzelner Fotos „bewegliche Porträts“ (Link zur Publikation der Forscher) herzustellen, in denen das Motiv sich bewegt und eine natürliche Mimik hat. Die Forscher haben solche Videos mit bereits verstorbenen Personen wie Mona Lisa, Albert Einstein und Marilyn Monroe produziert.

Mit der Deep-Fake-Technologie können sogar Videos mit der Mona Lisa erstellt werden

Angriff auf westliche Demokratien?

„Stellen Sie sich vor, so ein Video wird am Abend vor einer Wahl oder einer wichtigen politischen Entscheidung veröffentlicht“, sagte Rubio. Die Öffentlichkeit habe derzeit eine Neigung, haarsträubende Dinge zu glauben, und in den sozialen Medien könnten solche Videos schnell verbreitet werden.

„Ich glaube, dass so die nächste Welle an Angriffen auf Amerika und die westlichen Demokratien aussieht.“ Die Videos könnten nur nach intensiver Analyse als Fälschung entlarvt werden, wenn die Wahlen längst vorbei sind, befürchtet der republikanische Senator.

2017 tauchten pornografische Videos mit prominenten Schauspielerinnen und Musikerinnen im Netz auf. Deren Gesichter waren mittels Deep-Fake-Methode auf die Körper von Pornodarstellerinnen gelegt worden. Die Videos wurden als Fälschung entlarvt.

Betroffen war unter anderem Scarlett Johansson. Gegenüber der Washington Post sagte die Schauspielerin, sie werde nichts dagegen unternehmen, da es sowieso vergebens sei, zu versuchen, etwas aus dem Internet zu entfernen. Johansson schätzt, dass ihre Bekanntheit ihr einen gewissen Schutz gibt, zeigte sich jedoch besorgt, dass durch Deep-Fake-Pornografie dem Ansehen weniger bekannter Frauen geschadet werden kann.

Internetplattformen wie Reddit und Pornhub haben in der Zwischenzeit beschlossen, solche Inhalte nicht zu dulden. Kalifornien hat ein Gesetz verabschiedet, das es illegal macht, Deep-Fake-Pornos ohne die Einwilligung der Betroffenen herzustellen. Aber auch in anderen Ländern können solche Filme gegen das Gesetz verstoßen, zum Beispiel weil sie rufschädigend sind.

Deep Fakes schon in der Werbung

Ein Deep Fake hat es auch bereits in die Werbung geschafft. Die Organisation „Solidarité Sida“ lässt in einem gefälschten Video Präsident Donald Trump „Aids ist besiegt“ verkünden und folgt mit der Aussage: „This is fake news. The first fake news that could be true.“ Die Organisation setzt sich dafür ein, dass alle Betroffenen Zugang zu Medikamenten erhalten.

https://www.youtube.com/watch?v=dPkK8iohYLE&feature=youtu.be

Der belgische Journalist Tom Van de Weghe, der sich lange mit Deep Fake beschäftigt hat, schreibt: „Bislang ist die Apokalypse ausgeblieben, aber die Gefahren von Deep Fakes sind real. Sie können benutzt werden, um digitale Buschbrände zu legen. Sie können von autokratischen Regimes benutzt werden, um Dissidenten zu diskreditieren. Sie können Leute überzeugen, dass ein toter Führer noch lebt. Sie können falsche Aussagen erzeugen.“

Besonders Gemeinschaften, die keinen Zugang zu Mainstream-Medien haben und Informationen durch soziale Netzwerke beziehen, sieht er gefährdet. Die größte Gefahr sei aber, dass grundsätzlich allem misstraut wird. Dies könnte dazu führen, dass selbst an echten Videos gezweifelt wird und das Vertrauen in den Journalismus noch weiter sinkt.

Viele Menschen glaubten, so Van de Weghe, dass die US-Wahlen 2020 die erste richtige Probe für Deep Fakes werden. So lange dürfe man aber nicht warten. Bereits jetzt müsse ein Bewusstsein dafür geschaffen und die Medienbildung verbessert werden.

Sie müssen angemeldet sein um kommentieren zu können